梁文锋署名,DeepSeek再发论文

Share - WeChat

近日

DeepSeek团队发表新论文

论文以DeepSeek-V3为核心案例

披露其在AI硬件架构

与模型设计方面的关键创新

为实现具有成本效益的

大规模训练和推理提供思路

论文显示

DeepSeek创始人兼CEO梁文锋

也是参与者之一

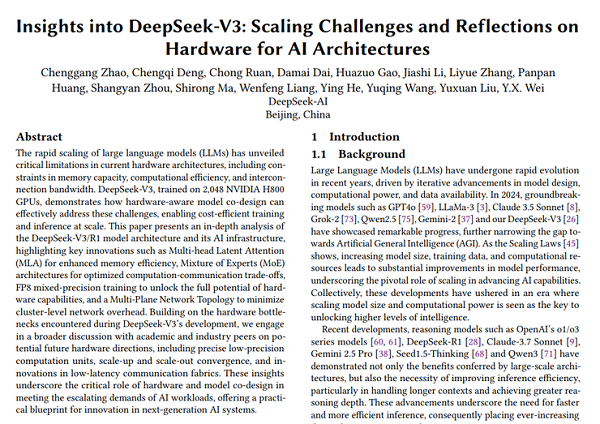

DeepSeek论文《深入解读 DeepSeek-V3:AI 架构的扩展挑战与硬件思考》

图源:论文截图

有业内人士表示

该论文聚焦“硬件-模型”

协同创新底层逻辑

直击当前大模型训练

与推理的效率痛点

一起来看↓

揭秘DeepSeek模型设计原则

在训练大模型这条路上

可以说一直有“三大难题”

内存不够用

计算效率低

通信速度慢

而这篇论文所要解决的

正是上述的这些问题

与此前发布的V3技术报告不同

这篇论文详细阐述了DeepSeek

如何做到在硬件资源的“紧箍咒”下

通过精妙的“软硬一体”协同设计

将成本效益这笔账算好

DeepSeek在论文中提到

本文的目的不是重申

DeepSeek-V3的详细架构和算法细节

是跨越硬件架构和模型设计

采用双重视角来探索它们之间

错综复杂的相互作用

以实现具有成本效益的

大规模训练和推理

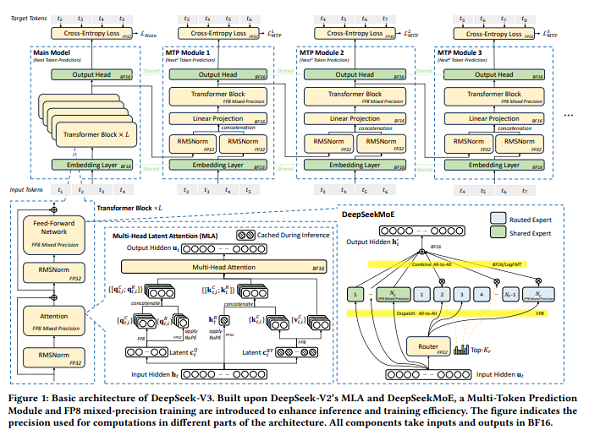

DeepSeek-V3的基本架构

图源:论文截图

具体而言

论文聚焦内存效率、成本控制、

推理速度等方面展开说明

DeepSeek模型设计原则

在内存效率方面

多头潜在注意力(MLA)技术

通过压缩键值(KV)缓存

缓存显著降低了内存消耗

FP8混合精度训练技术

将内存消耗显著降低了一半

从数据来看

相比其他模型

(如LLaMA-3、Qwen-2.5)

DeepSeek-V3的KV缓存大小

每token仅需70 KB

是传统方法的1/7到1/4

大幅降低显存压力

尤其适合长文本处理

在成本控制方面

DeepSeek开发了DeepSeek MoE架构

其两大优势包括降低训练成本

和利于个人使用和本地部署

在提高推理速度方面

DeepSeek-V3采用的是

多token预测(MTP)的方法

传统模型每次只能生成1个token

而MTP通过轻量级子模型并行

预测多个候选token

验证后选择最优结果

实验效果显示

生成速度提升1.8倍

OpenAI联合创始人

Andrej Karpathy此前赞叹

“DeepSeek-V3的出现

实现了高性能与低成本的平衡

未来或许不需要

超大规模的GPU集群了”

六大关键探索未来AI基础设施

下一代AI基础设施

将如何升级?

DeepSeek从硬件架构的角度

提出六大方向

涉及内存、互连、网络、

计算等核心领域

图源:虎嗅

整体来看,包括

“鲁棒性优先:

构建不易崩溃的训练系统”

“颠覆互连架构:

CPU-GPU直连消除节点瓶颈”

“智能网络升级:

动态路由实现低延迟”

“通信顺序‘硬件化’:

消除软件额外开销”

“网络计算融合:

硬件加速通信效率”

“内存架构重构:

从‘芯片堆叠’到‘晶圆集成’”

这些专业名词

非行家乍一看有些难懂

有业内人士“翻译”称

就是下一代AI硬件要向

算数快(低精度计算+本地细粒度量化)

传话快(直连网络+智能路由)

记性好(3D内存+近存计算)

不宕机(自愈网络)的方向改进

才能更好地应用于大模型训练

实现高效扩展

图源:网络

DeepSeek表示

这些内存中心的架构创新

旨在打破当前内存发展

滞后于模型规模扩张的瓶颈

是下一代AI系统持续迈向

“更大、更快、更稳”的关键路径之一

同时这些方案也在DeepSeek-V3

训练与推理实践中均取得了实效

为下一代高性能AI系统

构建了坚实的内存支撑基础

参考:上海证券报、财联社、量子位

撰文:雷渺鑫 编辑:李飞 排版:李汶键 统筹:李政葳

2022年7月12日,世界互联网大会国际组织正式成立,从互联网领域的国际盛会发展为国际组织,总部设于中国北京。我们将致力于搭建全球互联网共商共建共享平台,推动国际社会顺应信息时代数字化、网络化、智能化趋势,共迎安全挑战,共谋发展福祉,携手构建网络空间命运共同体。