OpenAI春季发布会:GPT-4o登场!与人类反应时间相近?

Share - WeChat

北京时间5月14日凌晨

美国人工智能研究公司OpenAI

举办春季发布会

发布了新旗舰模型GPT-4o

并展示了一些最新研究

只多一个“o”

却多了很多新功能

GPT-4o的“o”代表“omni”

源自拉丁语“omnis”

词意为“全能”

GPT-4o可以接受文本、音频和图像

三者组合作为输入

并生成文本、音频和图像的

任意组合输出

在GPT-4o之前

GPT-4无法直接观察音调、

说话的人和背景噪音

也无法输出笑声、

歌唱声和表达情感

GPT-4o可以在232毫秒内

对音频输入做出反应

与人类在对话中的反应时间相近

比如

GPT-4o能够从用户急促的喘气声中

理解“紧张”的含义

并指导用户进行深呼吸

还可以根据用户要求变换语调

图像输入方面

OpenAI高管启动摄像头

要求实时完成一个一元方程题

GPT-4o轻松完成了任务

ChatGPT桌面版

还能够对代码和气温图表

进行实时解读

性能方面

GPT-4o在文本、推理和编码等方面

实现了与GPT-4 Turbo

(OpenAI于2023年11月

发布的多模态模型)

级别相当的性能

同时

在多语言、音频

和视觉功能方面的表现分数

也创下了新高

什么时候能用到这些新品?

OpenAI介绍

将首先向ChatGPT Plus

和Team用户推出GPT-4o

并且很快会向企业用户推出

免费用户也有机会体验GPT-4o

但当达到限额时

ChatGPT将自动切换到GPT-3.5

发布会的“B面”

未提及“可持续性”

GPT-4o在响应速度方面

几乎解决了延迟问题

日本经济新闻报道称

克服这个弱点

让人工智能的使用

可能会变得更加广泛

NHK称

“IT公司之间的开发竞争正在加剧”

BBC认为

本次发布会向人们展示了

OpenAI的发展方向

GPT-4o打算成为下一代AI数字助理

但也提示

GPT-4o变得越复杂

就需要更多的算力

而本次发布会

没有提及“可持续性”

CNBC则在报道中指出

一些业内人士

对未经测试的新服务

进入市场的速度表示担忧

学术界和伦理学家

对该技术传播偏见的倾向感到苦恼

业界人士指出

尽管GPT-4o在多模态能力上

有所提升

但OpenAI并未展示出

真正的视觉多模态突破功能

在实时音频交互方面

市场上已有产品具备类似功能

ChatGPT虽处高光

背后也有危机

OpenAI CEO山姆·奥特曼

(Sam Altman)曾表示

未来五年

OpenAI最大的瓶颈

可能会出现在

供应链和计算资源方面

另一方面

OpenAI也一直因版权问题

受到质疑

发布会前不久

美国八家新闻机构提起诉讼

称其利用大量版权新闻文章

训练聊天机器人ChatGPT

控告OpenAI侵权

值得一提的是

OpenAI把此次发布会时间

安排在谷歌的I/O大会之前

(谷歌也将发布AI产品)

相当于给谷歌“甩了个王炸”

大家都在等着看

接下来谷歌如何“接招”?

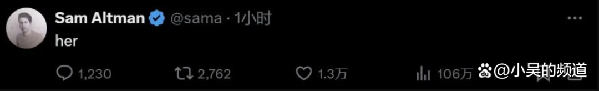

发布会结束后

奥特曼在个人社交平台

发布了一个单词:

她(her)

在科幻电影《她》里

AI助理爱上了人类

而今天

具备新功能、接入GPT-4o的

ChatGPT语音助手产品

似乎真的有望让科幻电影的桥段

走入现实

撰文:李飞、曾紫琪 编辑/排版:李汶键统筹:李政葳

参考丨OpenAI官网、日本经济新闻、BBC、CNBC、联合早报

2022年7月12日,世界互联网大会国际组织正式成立,从互联网领域的国际盛会发展为国际组织,总部设于中国北京。我们将致力于搭建全球互联网共商共建共享平台,推动国际社会顺应信息时代数字化、网络化、智能化趋势,共迎安全挑战,共谋发展福祉,携手构建网络空间命运共同体。