算力不足!OpenAI的大模型GPT-5“难产”

Share - WeChat

当地时间12月20日

《华尔街日报》报道

OpenAI的新一代人工智能项目

GPT-5

正面临重重困难

报道称

该项目已开发超过18个月

成本花费巨大

却仍未取得预期成果

GPT-5有多厉害?

OpenAI首席执行官

山姆·奥特曼(Sam Altman)曾表示

GPT-4

表现得像一个聪明的高中生

但GPT-5

在某些任务上

更像拥有博士学位

相比于此前的模型

GPT-5将是一次“重大飞跃”

《华尔街日报》报道称

OpenAI希望

GPT-5能够解锁新的科学发现

并完成诸如预约等日常人类任务

相比于其他AI模型

GPT-5能够出现更少错误

在参数方面

GPT-4参数约为2万亿

而GPT-5参数预计有52万亿

这一庞大的参数规模

暗示了其潜在的强大能力

算力成本制约大模型发展

自2023年3月GPT-4发布以来

OpenAI一直在推进GPT-5的研发工作

至今已超18个月

作为OpenAI的最大投资者

微软原本希望能够在

2024年年中看到新模型的问世

但这一目标并未实现

原因在哪?

《华尔街日报》爆料称

GPT-5的大规模训练至少进行了2轮

每次长达数月

但是每次训练后都遇到新问题

估算显示

GPT-5一次为期6个月的训练

仅计算成本就高达约5亿美元

这是2024年11月19日拍摄的超大规模算力并网、算网大脑技术创新与应用项目发布现场。图源:新华社

对大模型来说

算力越大越好

业内形象地说是“大力出奇迹”

然而

大算力意味着巨大的成本

山姆·奥特曼此前表示

由于计算能力的限制

公司无法按预期频率推出新产品

优质数据不足,合成数据来凑

业内人士表示

2024年

全球训练大语言模型的效果

普遍不及预期

可能已经撞上“数据墙”

如OpenAI产品迭代明显放缓

Anthroipc暂停Calude 3.5 Opus开发

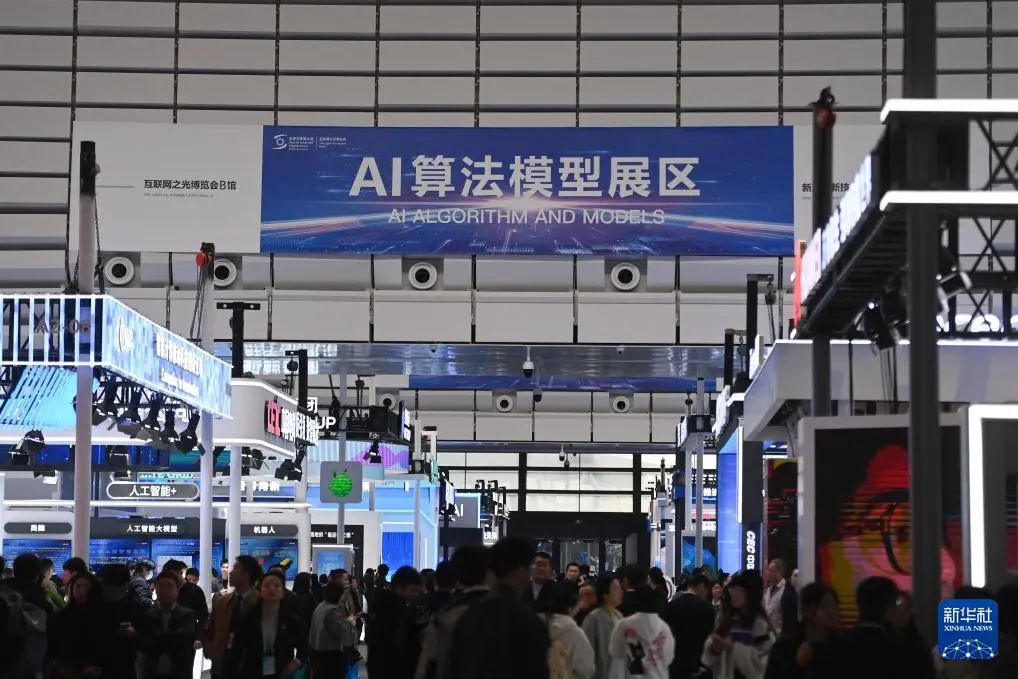

2024年11月19日,观众在2024年世界互联网大会“互联网之光”博览会上参观。图源:新华社

为了解决这类问题

OpenAI选择从头开始创建数据

他们雇佣软件工程师等专业人士

编写新代码或解决数学问题

以此作为训练数据

但这个过程非常缓慢

即便有1000人每天写5000字

数月之内也只能产生10亿个token

(数据或文本的最小单元)

而仅GPT-4的训练

就使用了大约13万亿个token

OpenAI也开始开发合成数据

解决数据短缺问题

合成数据初创企业

Gretel.ai的首席执行官认为

合成数据既能保护隐私

又能保持数据的统计完整性

不过

也有人不看好合成数据

来自牛津、剑桥、帝国理工等

机构研究人员发现

如果在训练时大量使用AI内容

会引发模型崩溃

造成不可逆的缺陷

面对AI行业面临的问题

OpenAI的前首席研究官

鲍勃·麦格认为

大模型还有非常大的进步空间

但这是一个缓慢的

需要数年来完善的过程

360集团创始人周鸿祎此前表示

随着人工智能大模型技术的深入应用

其涉及的数据量、算法复杂性

应用场景的广泛性

都达到了前所未有的高度

其发展方向和安全把控

涉及社会经济、安全等方面

他表示

确保人工智能

安全、向善、可信、可控

是人工智能发展

必须解决的重要课题

2022年7月12日,世界互联网大会国际组织正式成立,从互联网领域的国际盛会发展为国际组织,总部设于中国北京。我们将致力于搭建全球互联网共商共建共享平台,推动国际社会顺应信息时代数字化、网络化、智能化趋势,共迎安全挑战,共谋发展福祉,携手构建网络空间命运共同体。